仍然不知道在 Hot Docs 上看什么? 无论您是否在多伦多,这里都有最后一刻的指南

来不及查看今年 Hot Docs 的热门内容? 或者您无法参加安大略省音乐节,该音乐节取消了其流行的家庭流媒体选项? 没有恐惧。 CBC News 整理了一些电影节上最值得您花时间观看的最佳纪录片。 其中包括截至周三上午仍有门票可用的一些电影,以及多伦多以外的电影观众今年晚些时候可以在家里或其他地方观看这些电影的时间和地点的信息。 该节日将于4月25日至5月5日举行。 任何其他方式:杰基·谢恩的故事 播放了杰基·谢恩 (Jackie Shane) 生平纪录片中的动画。 (邦格电影/NFB) 出生于纳什维尔的一位独一无二的跨性别 R&B 表演者在 20 世纪 60 年代的多伦多找到了自己的舞台和精神家园。 然后,她就消失了。

迈克尔·莫斯利博士揭示一茶匙“强力”零食可以降低患心脏病的风险

饮食 是我们整体健康和福祉的一个关键因素。 我们中的许多人都意识到我们应该吃健康、均衡的饮食,其中含有大量的 水果 和 蔬菜 为此原因。 然而,即使有最好的意图,也很难确保我们从膳食中获得所需的所有营养。 因此,一位专家建议仅添加少量他称之为“营养强国”的食物,以帮助降低患此病的风险。 心脏病 和高 血压,甚至提高你的 皮肤。 谈到他的 英国广播公司 播客 就一件事饮食大师迈克尔·莫斯利博士提到了一种具有显着健康益处的种子。 所讨论的种子是亚麻籽 – 也称为亚麻籽。 莫斯利博士称它们为“富含纤维、蛋白质和健康脂肪酸的营养动力源”。 它们以其温和的坚果味而闻名,可以很容易地添加到人们的饮食中,撒在粥上,添加到沙拉中,甚至烘烤成面包和松饼。 莫斯利博士表示,亚麻籽磨成粉末后吸收效果更好。 研究人员认为,其中一些好处可能是亚麻籽中富含一种名为 α

关于包裹你的汽车你需要知道什么 – 温尼伯自由报

下次当你遇到交通堵塞时,环顾四周,看看你是否对周围单色的海洋感到惊讶,甚至有点悲伤。 现代汽车有各种各样的形状和尺寸,但很少有人探索色轮中更鲜艳的色调。 什么是乙烯基包装? Edmunds 提供的这张照片显示了一辆装有售后乙烯基包装的 2017 款 Tesla Model 3。 包裹您的车辆可以让它看起来清新而独特。 (埃德蒙兹通过美联社提供) 乙烯基包装材料是一片薄膜,经过精确切割并使用热风枪和温和的粘合剂粘贴到汽车的车身面板上。 它们经久耐用,价格相对实惠,如果保养得当,可以使用五年左右。 如果您感到无聊,它们也相对容易移除。 它们也是一种快速增长的汽车定制趋势。 如果您曾经见过带有变色龙、类似镀铬饰面、条纹和迷彩等图案的汽车,或者只是另类的粉色或柠檬绿,那么您很可能见过乙烯基包装。 它们甚至可以结合图形、徽标和文本,提供一种理想的产品和服务广告方式。 您唯一的限制是预算和想象力。 它们要花多少钱? 就像新的油漆工作一样,包装汽车的成本取决于尺寸、风格和安装难度。 预计花费约 3,000 美元为本田思域等小型轿车进行光面或哑光饰面贴膜。 对于SUV来说,价格将上涨至4000美元左右。

Popular Stories

利比亚与摩洛哥友谊:利比亚居住费飞涨

主要的/消息/利比亚与摩洛哥友谊:利比亚居住费飞涨 新闻利比亚 2024 年 4 月 24 日 凌晨 4:55 0 0 利比亚-摩洛哥友好协会 – 利比亚 利比亚新闻24 利比亚-摩洛哥友好协会主席穆罕默德·哈桑·瓦蒂克表示,利比亚的居住费、签证和相关服务的费用都在上涨,他称之为“飞涨”。 瓦蒂克在他监控的新闻声明中解释道 《利比亚新闻24》 达拜巴政府发布了一项决定,其中包括增加获取和续签签证和居留卡的费用,此外还批准对签证或居留期满后违反在利比亚领土停留的行为处以每月 500 第纳尔的罚款。 利比亚与摩洛哥友谊:利比亚居住费飞涨 瓦蒂克:这些决定将导致居住在利比亚的摩洛哥人的处境恶化 瓦蒂克补充说,这些决定将导致居住在利比亚的摩洛哥人的法律、经济和社会条件恶化,并指出这些决定与利比亚摩洛哥人的处境不符,他们多年来因缺乏领事服务而遭受苦难。以获得更新居留权所需的文件。

“人们只关注他们最喜欢的大乐队的完整专辑,”Indrid 的成员感叹道。

Indrid(Barakaldo,2016)是一个比其艺名更神秘的吉他摇滚乐队,在其第四张专辑《XIII》中,标题为“13”,指的是其所谓的厄运,同样指的是英雄的意思。比起米克尔·比扎尔 (Mikel Bizar) 的城市史诗,或者是从西雅图到斯堪的纳维亚半岛的粗暴的九十年代摇滚(有一首歌是来自 Porco Bravo 的 Manu 合作的),以及值得对管弦乐感兴趣的汉斯·齐默 (Hans Zimmer) 的配乐, (开场乐器)。 贝斯手、作词家兼 Indrid 创始人 Andoni Darko 和他的表弟吉他手 Kitxu(自 90 年代末以来,这两位表弟都曾在其他冒险经历中重合)向我们介绍了这个四重奏。 你更喜欢摇滚还是更喜欢金属迷? 我们聆听摇滚和金属的各个方面,在作曲时,会出现不同风格的接触。 乐队的每个成员都根据自己喜欢的音乐流派贡献自己的想法,这让乐队变得更加丰富。

托特纳姆谋杀案:28 岁男子因刺伤在克罗伊登被捕

4 月 7 日凌晨 5 点 5 分,一名男子被发现失去知觉后,紧急服务人员接到电话前往托特纳姆的伍斯特大道。 抵达后,他们发现 46 岁的 Okechukwu Iweha 身上有刺伤。 尽管紧急服务部门做出了努力,但他还是被宣布当场死亡。 奥克楚库的家人继续得到伦敦警察厅专家的支持。 4 月 10 日在哈林盖太平间进行的尸检显示,他的死因是胸部刺伤。 受害者奥克丘库·伊维哈 (图片:大都会) 4 月 22

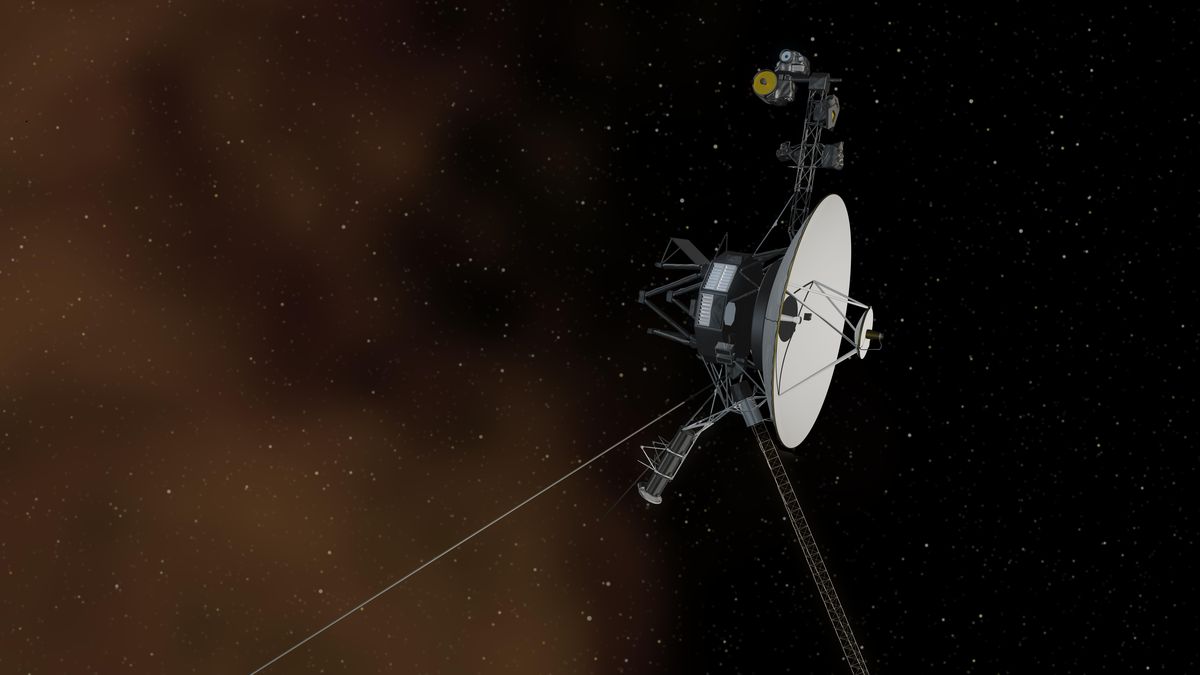

五个月后,航行者一号发回可读数据

NASA 的航行者 1 号航天器于 2023 年 11 月 14 日停止向地球发送可读的科学和技术数据。 现在,自去年 11 月以来,它首次向地球上的控制中心发送有关其机载工程系统状态的可操作数据。 正如美国宇航局自己所写的那样,下一步是让探测器再次开始发送科学数据 网站。 问题出在芯片上 近半个世纪前被送入太空的旅行者一号探测器显然在“沉默”期间仍能接收到 NASA 团队的指令,并且显然功能正常,但它没有发回科学数据或有关其技术状况的信息。 天文学家揭示了天王星和海王星行星的真实颜色 科学与学校 根据美国宇航局位于加利福尼亚州的喷气推进实验室(JPL)的说法,问题出在其中一台机载计算机中的一个芯片上,该计算机负责在将科学和技术数据发送到地球之前对其进行格式化。 该芯片无法修复,但程序员设法将有问题的代码从地球移动到相应计算机内存中的另一个位置。 NASA 指出,该信号需要