“值得称赞”和“一丝不苟”等词的过多暗示了 ChatGPT 在数千项科学研究中的使用 | 技术

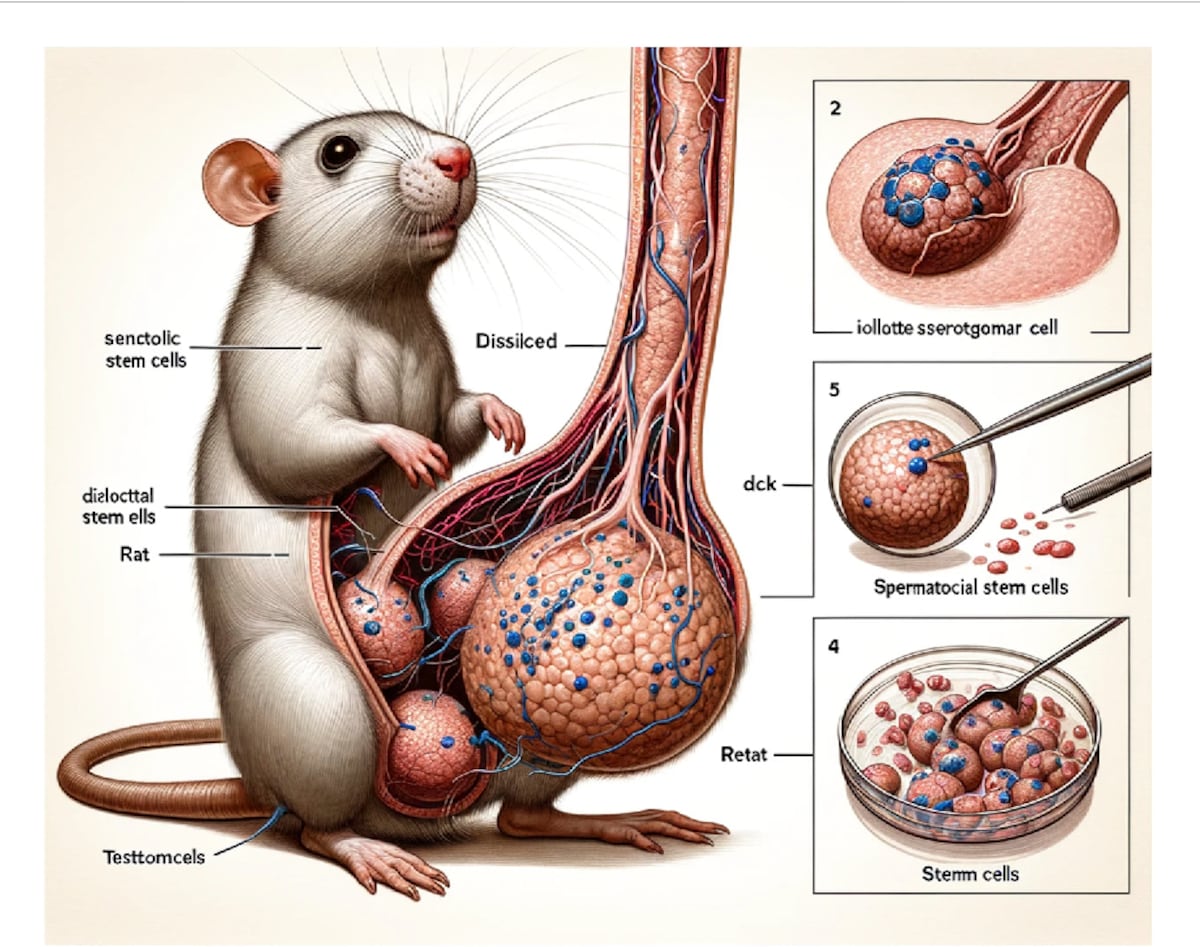

图书管理员 安德鲁·格雷 有了一个“非常令人惊讶”的发现。 他分析了去年发表的 500 万份科学研究,并发现 突然高 在他们的英文版本中,某些词语的使用存在差异,例如细致地(上升137%)、复杂(117%)、值得赞扬(83%)和细致(59%)。 伦敦大学学院的格雷只能找到一种解释:数以万计的研究人员正在使用 ChatGPT – 或其他类似的人工智能语言生成程序 – 来撰写他们的研究或至少“润色”它们。 有明显的例子。 中国科学家团队2月17日发表 一项研究 关于锂电池。 这项工作发表在爱思唯尔出版社的一本专业杂志上,开头是这样的:“当然,这里有一个可能的主题介绍:锂电池是……的有前途的候选者”。 作者显然要求 ChatGPT 提供介绍并按原样复制。 其他 文章 以色列研究人员于 3 月 8 日签署的另一本爱思唯尔期刊中包含这样的文字:“总而言之,双侧医源性损伤的管理我很抱歉,但我无法获得实时信息或患者特定数据,因为我是一个人工智能语言模型。” 几个月前,三名中国科学家发表了一幅疯狂的图画,画的是一只长着巨大阴茎的老鼠,这是一张由人工智能生成的图像 一项研究 关于精子前体细胞。 更多信息 Andrew Gray 估计,至少 60,000 项科学研究(超过 2023 年分析的科学研究的 1%)是在 ChatGPT(2022 年底推出的工具)或类似工具的帮助下撰写的。 “我认为用 ChatGPT 撰写完整研究的极端案例很少见,”41 岁的苏格兰图书馆员 Gray 说。 在他看来,大多数情况下,人工智能被适当地用来“润色”文本——识别错别字或方便翻译成英文——但存在很大的灰度,其中一些科学家进一步利用ChatGPT的帮助,而没有验证结果。 “现在不可能知道这个灰色地带有多大,因为科学期刊不要求作者声明使用 ChatGPT,透明度非常低,”他感叹道。 正如该团队所表明的那样,人工智能语言模型不成比例地使用某些单词。 詹姆斯·邹,来自斯坦福大学(美国)。 这些术语往往具有积极的含义,例如值得称赞、细致、复杂、创新和多才多艺。 […]