OpenAI 的新 GPT-4o 让人们可以在同一模型中使用语音或视频进行交互

GPT-4 提供了类似的功能,为用户提供了多种与 OpenAI 的 AI 产品交互的方式。 但它将它们隔离在不同的模型中,导致响应时间更长,计算成本可能更高。 GPT-4o 现在已将这些功能合并到一个模型中,Murati 称之为“全模型”。 她说,这意味着任务之间的响应速度更快,过渡更顺畅。 该公司的演示表明,其结果是一款类似于 Siri 或 Alexa 的对话助理,但能够处理更复杂的提示。 “我们正在研究我们自己与机器之间交互的未来,”穆拉蒂在谈到演示时说道。 “我们认为 GPT-4o 确实正在将这种范式转变为协作的未来,使这种交互变得更加自然。” OpenAI 的研究人员 Barret Zoph 和 Mark Chen 介绍了新模型的一些应用。 最令人印象深刻的是它的现场对话设施。 你可以在模型响应期间打断它,它会停下来、倾听并调整路线。 OpenAI 还展示了改变模型基调的能力。 陈要求模特读一个“关于机器人和爱情”的睡前故事,并迅速插话要求模特发出更戏剧化的声音。 该模型逐渐变得更加戏剧化,直到穆拉蒂要求它快速转向令人信服的机器人声音(它擅长这一点)。 虽然在模型推理接下来要说什么的过程中,对话过程中出现了一些短暂的停顿,但它作为一场节奏非常自然的人工智能对话脱颖而出。 2024-05-13 19:27:57 1715674913

OpenAI 推出更快且免费的 GPT-4o 模型 – 新的语音助手说话非常自然,你会认为它是恶作剧的

前瞻性: OpenAI 刚刚推出了 GPT-4o(GPT-4 Omni 或简称“O”)。 该模型并不比 GPT-4“更智能”,但仍然有一些显着的创新使其与众不同:同时处理文本、视觉和音频数据的能力,询问和回答之间几乎没有延迟,以及令人难以置信的人类声音。 虽然当今的聊天机器人是有史以来最先进的聊天机器人,但它们都存在高延迟问题。 根据查询的不同,响应时间可以从一秒到几秒不等。 苹果等一些公司希望通过设备上的人工智能处理来解决这个问题。 OpenAI 对 Omni 采取了不同的方法。 周一,Omni 的大部分回复都很快 示范,使对话比典型的聊天机器人会话更加流畅。 它还优雅地接受打扰。 如果演示者开始谈论 GPT-4o 的回复,它会暂停正在说的话而不是完成其回复。 OpenAI 将 O 的低延迟归功于该模型处理所有三种形式输入(文本、视觉和音频)的能力。 例如,ChatGPT 通过单独模型的网络处理混合输入。 Omni 处理一切,将其关联成一个有凝聚力的响应,而无需等待另一个模型的输出。 它仍然拥有 GPT-4“大脑”,但具有可以处理的其他输入模式,OpenAI 首席技术官 Mira Murati 表示这应该成为常态。 “GPT-4o 提供 GPT-4 级别的智能,但速度要快得多,”Murati 说。 “我们认为 GPT-4o 确实正在将这种范式转变为协作的未来,使这种交互变得更加自然和容易。” Omni 的声音(或多个声音)在演示中最为突出。 当演示者与机器人交谈时,它会用随意的语言进行回应,其中夹杂着听起来很自然的停顿。 它甚至咯咯地笑,赋予它一种人类的品质,让我怀疑它是计算机生成的还是伪造的。 真实的专家和纸上谈兵的专家无疑会仔细审查这些镜头以验证或揭穿它。 我们看到了同样的事情 发生 当谷歌推出 Duplex 时。 谷歌的数字助手最终 […]

OpenAI 的 GPT-4o 模型为 ChatGPT 带来了敏捷、性感的升级

自 2022 年底推出以来,OpenAI 的 ChatGPT 通常会回应称它只是一个人工智能模型,以此来回避有关它有情感或欲望的暗示。 OpenAI 周一宣布的升级表明,该公司显然试图让聊天机器人表现得更像人类。 在演示中,新版本的 ChatGPT 能够进行快速、自然的语音对话,捕捉情绪线索,并显示自己的模拟情绪反应。 周一,在旧金山公司总部的直播中,OpenAI 首席技术官 Mira Murati 宣布 ChatGPT 将由一种名为 GPT-4o 的新的、更强大的 AI 模型提供支持。 ChatGPT 的免费和付费用户将可以通过新的桌面应用程序以及现有的移动应用程序和网络版本使用该模型。 Murati 表示,GPT-4o 模型使 ChatGPT 能够比 OpenAI 之前的技术更快地响应语音、图像和视频输入。 在演示中,她和其他 OpenAI 员工与 ChatGPT 进行了快速流畅的对话,ChatGPT 使用活泼且富有表现力的女性声音进行应答,并在被打断时灵活地跟上。 ChatGPT 在谈话过程中采用了不同的情绪语气,有时做出反应,就好像它正在经历自己的感受一样。 当一名 OpenAI 员工说他一直在谈论这个聊天机器人是多么“有用和神奇”时,它轻浮地回应道,“哦,别说了,你让我脸红了。” “这感觉太神奇了,太棒了,”穆拉蒂补充道,“在接下来的几周内,我们将向所有人推出这些功能。” 在演示的另一个时刻,ChatGPT 回应了 OpenAI 研究员 Barret Zoph 的问候,问道:“今天我怎样才能让你的一天开心起来?” 当 Zoph 要求聊天机器人看他的自拍照并说出他所表现出的情绪时,ChatGPT 回应道:“我会戴上我的情感侦探帽”,并热情地说:“看起来你感觉非常快乐和开朗……不管发生什么事,看起来你心情很好。” 在 […]

ChatGPT 携 OpenAI 最新 GPT-4o 模型登陆桌面,可与用户对话

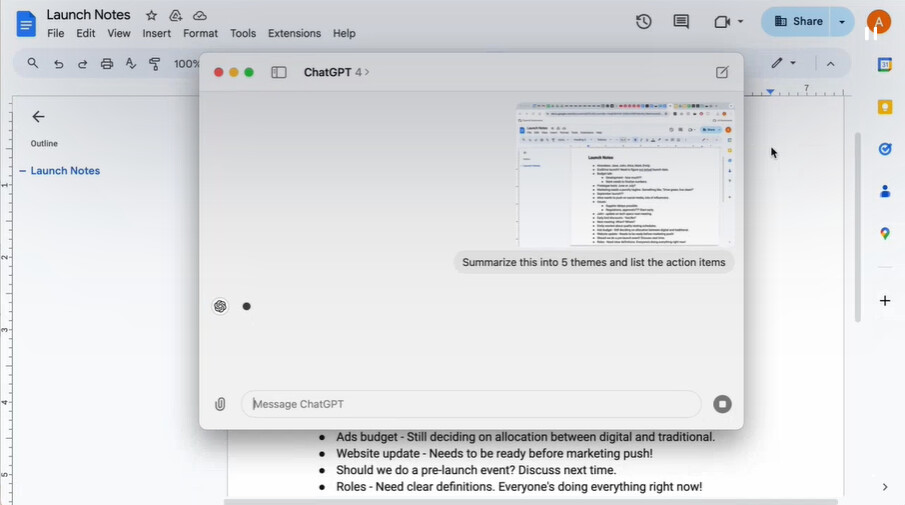

在 OpenAI 的春季更新中,很多目光都集中在该公司,ChatGPT 应用程序刺激了 AI 热潮。 ChatGPT 现在几乎成为消费者和产消者的必备应用程序,它是最新人工智能创新的实际应用程序,得到了 OpenAI 研究人员和科学家的支持。 今天,OpenAI 宣布推出名为 GPT-4o(Omni)的新模型,希望带来先进的智能、提升的整体能力以及与用户的实时语音交互。 现在,ChatGPT 应用程序希望成为一个私人助理,主动与用户沟通并提供更广泛的功能。 OpenAI 声称其对音频输入的响应速度最快可达 232 毫秒,平均为 320 毫秒,与人类对话中的响应时间相似。 然而,OpenAI 表示,它希望 ChatGPT 的最新 GPT-4o 模型可供免费、Plus 和 Team 付费订阅者使用,其中付费订阅者的使用率提高 5 倍,并可以提前访问该模型。 有趣的是,GPT-4o 模型在 MMLU、Math、HumanEval、GPQA 等各种标准基准测试中得到了很大改进,现在它超越了 MGSM 中除 Claude 3 Opus 之外的几乎所有模型。 它现在可以理解 50 多种语言,并可以进行实时翻译。 除了新模型之外,OpenAI 还宣布他们正在推出一款桌面 ChatGPT 应用程序,该应用程序可以充当个人助理并查看屏幕上发生的情况,但只有用户命令才允许。 这应该会带来更加精致的用户体验,并使用户能够使用人工智能作为第三人来帮助理解屏幕内容。 最初仅在 macOS 上可用,我们正在等待 OpenAI 推出 […]

OpenAI 推出了全模态 AI GPT-4o。 它的行为已经几乎像人类一样,因为它看到并听到它 – Živě.cz

OpenAI 今晚早些时候吹嘘 春季新闻。 对于广大公众来说,最重要的一个承诺是 将逐步免费发布一堆高级功能。 免费 ChatGPT 的用户将因此获得具有 GPT-4 功能的聊天机器人,该机器人还将在互联网上搜索答案,并能够分析上传的文件,包括照片。 同样,GPT 商店及其专门的 GPT 机器人最终将推出免费版本。 全模式 GPT-4o 可以理解文本、图像和声音 那些订阅 ChatGPT Plus 的人呢? 如果每个人都获得 GPT-4 级别的 AI,这是否意味着那些拥有统一费率的人将能够访问下一代 GPT-5? 不,至少现在是这样。 带着 GPT-4o 在伦敦漫步: 相反,他们将能够提前体验热门新产品 GPT-4o。 虽然之前的 GPT-4v 可以分析图像(V 代表 Vision),但这次末尾的字母“O”代表“Omni”——即 全模态 人工智能。 因此,GPT-4o 理解: 因此,这是我们已经可以在 ChatGPT 移动应用程序中使用的功能的完成工作,您只需切换到 语音模式 你可以用自然的捷克语与人工智能交谈。 付费 ChatGPT Plus 中的 GPT-4o 他的反应和人类一样快 然而,到目前为止,已经出现了几种不同的孤立模型。 GPT-4o 可以单独完成这一切,因为它已经在所有三个提到的领域中进行了学习。 […]

OpenAI 推出 AI 模型 GPT-4o 并从 ChatGPT 发布 macOS 应用程序 – IT 专业人士 – 新闻

:strip_exif()/i/2005545080.jpeg?f=meta)

OpenAI 在春季更新期间推出了新的人工智能模型 GPT-4o。 据 OpenAI 称,该模型的速度是 GPT-4 Turbo 的两倍,并且可供所有用户使用。 该公司还在 macOS 上发布了 ChatGPT。 根据 OpenAI GPT-4o“更快”,该模型提高了文本、图像和音频的可能性。 虽然 GPT-4 模型以前仅向付费用户提供,但 GPT-4o 模型将在“未来几周内”免费向所有用户提供。 然而,付费用户的限制要高出五倍。 名称中的“o”代表 Omni,这应该表明该模型的多功能性。 OpenAI 首席执行官 Sam Altman 报告 X 该模型是“原生多模态”,使其能够“理解”语音、文本和图像中的命令。 GPT-4o 也将可用于 API。 该型号的价格是 GPT-4 Turbo 的一半,并支持高出五倍的限制。 GPT-4o 还改进了 ChatGPT 的语音模式,使聊天机器人能够更好地充当智能助手。 该模型可以“实时”响应用户的问题。 OpenAI 写道 该模型平均需要 320 毫秒才能响应。 这与人类的反应时间相当。 据 OpenAI 称,使用 GPT-4,ChatGPT 仍然需要平均 2.8 […]