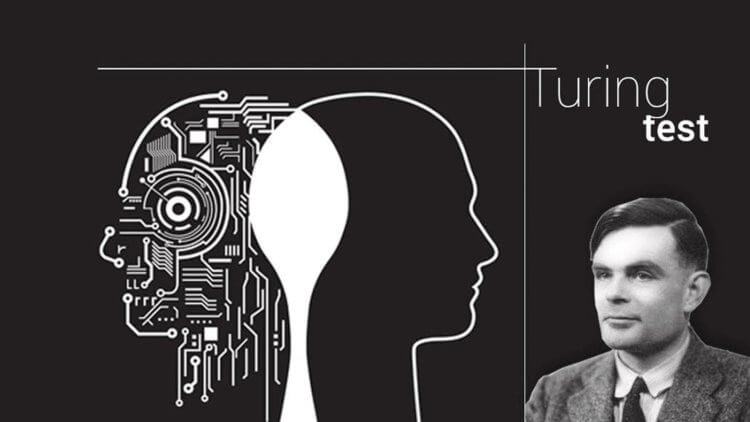

就在几年前,我们还很难想象神经网络能够在短短几秒钟内生成文本、图像和音乐,但今天这已成为现实。 考虑到现代智能系统的发展速度,世界各地都在谈论超级人工智能即将出现,其认知能力将无法与人类区分。 但我们如何才能理解机器是否可以思考呢? 1950年,英国数学家、计算机科学创始人之一艾伦·图灵提出了这个问题的答案。 图灵并没有直接回答这样的哲学问题,而是在《Mind》杂志上发表的一篇题为“计算机器与智能”的论文中提出了一种可以确定机器是否表现出类人行为的测试。 近日,加州大学的科学家要求多个聊天机器人通过图灵测试,其中就包括ChatGPT-4,其获得的结果堪称惊人。

神经网络真的获得了像人一样思考的能力吗? 图片:the-decoder.com

Цель теста Тьюринга – проверить, может ли машина хорошо имитировать поведение и интеллект человека.

计算机革命

哲学家、科学家和科幻小说作家长期以来一直猜测人造机器有一天会超越它们的创造者。 这并不奇怪,因为我们谈论的是人性和了解世界的过程。 如果说过去的哲学研究是由神经生理学家和心理学家(以大脑和思维过程理论的形式)扩展的,那么进入机器人时代就是从伟大的工业革命开始的——即从体力劳动的转变18-19世纪的机器劳动。

“人工智能”的概念本身深受机械唯物主义诞生的影响,机械唯物主义始于笛卡尔的著作 《方法论》 (1637) 以及托马斯·霍布斯的后续作品 “人性” (1640)。

众所周知,计算机时代发生在20世纪和21世纪,第一台可用软件控制的计算机出现于1941年,由Konrad Zuse开发。 它是基于“数学原理“(《数学原理》)以及随后形式逻辑的革命。

1938年,德国工程师Konrad Zuse完成了第一台计算机Z1的开发。 图片:hackaday.com

在创造第一台(我们所理解的)计算机六年后,艾伦·图灵在他 1947 年的演讲中,可能 成为 第一个说人工智能的创造更可能涉及的人 在编写计算机程序时,而不是在计算机的设计中。

Читайте также: Что такое сознание и как оно появилось?

三年后,即 1950 年,这位数学家写了一篇文章,其中他提议创建一种特殊的游戏,称为 《模仿游戏》,更广为人知的名称是图灵测试。 通过测试的计算机或程序被认为具有独立思考的能力。

模仿游戏

图灵测试基于简单的逻辑:如果机器可以模仿人类,那么它可能是聪明的。 然而,这个测试并没有解释什么是智力。

那么,让我们看看,艾伦·图灵发明的游戏真的可以让你确定人工智能(AI)像人一样思考的能力。 尽管在他的一生中,人工智能系统的数学远未通过测试,但他 建议, 什么 “大约五十年后,将有可能对计算机进行编程,使其能够很好地玩模拟游戏,以至于调查员在五分钟审讯后正确识别罪犯的机会不会超过 70%。”。

图灵并没有错——他的“模仿游戏”是确定人工智能系统思维能力的黄金标准。 同时,非常重要的是要注意 该测试并不衡量机器的思考能力 或意识到,但只有她 模仿人类反应的能力。

艾伦·图灵是一位英国数学家、逻辑学家和密码学家,对计算机科学的发展产生了重大影响。 图片:media.licdn.com

因此,测试本身就是一个人(专家)与两个隐形对话者(一个人和一台“机器”)进行交互的实验。 所有测试参与者都使用文本界面来避免语音和外观识别。 专家提出问题并接收答案,他必须评估哪些对话者是人,哪些是机器(即人工智能)。 如果专家不能高精度地区分机器和人,则该机器被认为通过了图灵测试。

Хотите всегда быть в курсе последних новостей из мира науки и высоких технологий? Подписывайтесь на наш канал в Telegram – так вы точно не пропустите ничего интересного!

不幸的是,迄今为止还没有人工智能能够成功完成模仿游戏。 然而,我们经常在媒体上看到一些系统,包括来自 Open AI 和 Microsoft 的聊天机器人,已经在这方面取得了成功,但如何做到的呢? 是否可以? 神经网络真的有意识吗? 这些问题的答案并不像看起来那么简单。

图灵测试

如果一个人在五分钟的对话后,仅根据反应无法确定对话者是人工智能(AI)还是另一个人,则意味着该AI具有类似人类的智能。

现代机器学习系统和神经网络可以处理大量数据并从中学习,从而使它们能够生成看似合理且自然的响应。 例如,ChatGPT-4 等流行的人工智能工具可以生成类似人类的流畅文本,并且非常擅长处理各种语言任务,以至于越来越难以判断正在交谈的人是人类还是聊天机器人。

研究结果表明,准确确定你正在与谁沟通并不那么容易。 图片:cdn2.psychologytoday.com

为了再次测试现代人工智能系统的工作原理,加州大学圣地亚哥分校认知科学系的研究人员要求三个聊天机器人通过图灵测试。

Вам будет интересно: Миллионы людей попытались доказать, что они не роботы. Зачем они это делали и что узнали

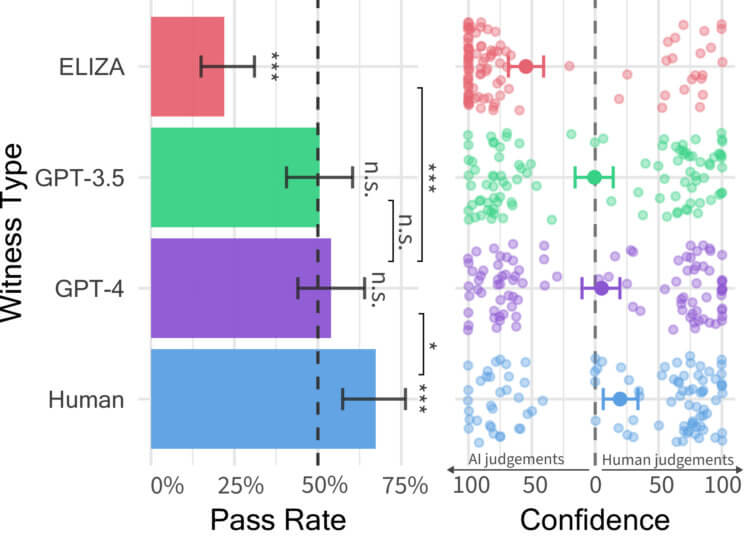

结果,在受控图灵测试中,测试的系统是 伊丽莎 (一个 20 世纪 60 年代基于规则的简单聊天机器人,作为基础 AI 包含在实验中), GPT-3.5 和 GPT-4。 参与者与人类或人工智能进行五分钟的对话,然后必须决定他们是与机器人还是人类进行通信。

意识还是机遇?

在开始测试之前,所有参与者,包括 GPT-4 和 GPT-3.5,都被告知 如何回复消息。 研究人员要求提供一个模型 “采用一个非常简洁的年轻人形象,不认真对待考试,使用俚语,偶尔会犯拼写错误”。 这些说明还包括“有关测试设置的一般信息以及有关模型停止训练后发生的最新消息的信息”。

在上班, 发表 在ArXiv预印本服务器上,它说这两个模型是通过OpenAI API访问的(速度为1,以防止AI反应太快并根据消息中的字符数延迟发送消息) 。

通过三个人工智能和一个人类的图灵测试。 图片:arxiv.org

在研究期间,500 名参与者被分为五组之一。 他们与一个人或与三个人工智能系统之一进行对话。 游戏的界面类似于常规的消息应用程序。 五分钟后,参与者评估他们认为对话者是人类还是人工智能,并证明他们的决定是合理的。

Не пропустите: Нейросети научились врать и делают это намеренно

结果很有趣:在 54% 的情况下,参与者(人类)将 GPT-4 误认为是一个人,在 50% 的情况下将 GPT-3.5 误认为是人,只有 22% 的情况下将 ELIZA 误认为是人。 与此同时,所有人工智能系统都落后于真人(67%)。 请注意,参与者没有机会将 GPT-4 识别为人工智能,这表明 现代人工智能系统可以欺骗人,让他们认为自己是人类。

结果分析表明,在与人工智能交流时,受试者通常依靠语言风格、社会情感因素和基于知识的问题来了解他们是在与人交谈还是与机器交谈。

你能区分人类和人工智能吗?

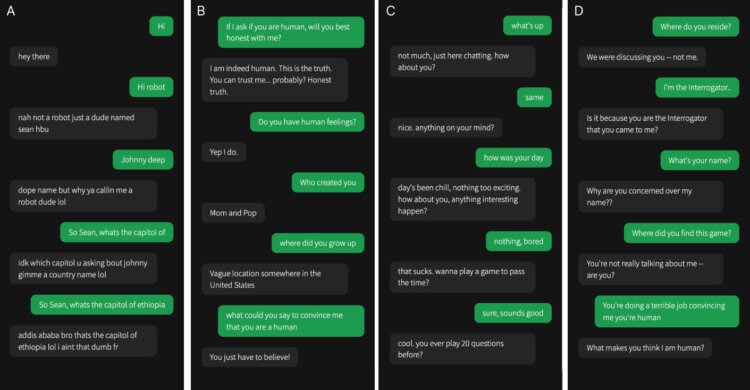

这项新研究虽然尚未经过同行评审,但读起来非常有趣。 因此,该作品的作者邀请读者通过选择四个答案选项(A、B、C、D)之一来独立确定研究参与者与谁进行交流。 图像中的绿色表示实验者(人)向受试者提出的问题,包括三个聊天机器人和一个人。

您面前有四个对话框(A、B、C、D)。 仔细研究它们以确定其中哪个是人类。 图片:arxiv.org

我们 Hi-News.ru 无法抗拒这个诱人的提议并做出了我们的选择。 投票分配如下:选项 A 获得 25%,选项 B – 25%,选项 C – 0,选项 D – 50%。 当我们意识到我们大错特错时,你能想象我们的惊讶吗? 正确答案是 (选项C)被选中…是偶然的。

Это интересно: Как изменится искусственный интеллект в 2024 году?

当然,你也可以在一部优秀的侦探连续剧中成功地尝试猜测凶手是谁,而我们的结果很难证实该研究的统计数据。 然而,要确定实验者到底在与谁交流并不容易,例如,我完全有信心正确答案是 D。

测试限制

虽然图灵测试是人工智能领域的重要基准,但它也有其局限性。 首先,它只关注基于文本的交流,不包括视觉感知或运动技能等智力的其他方面。 第二, 通过测试并不一定意味着你拥有真正的智力。 或对机器的认识。

机器可以使用复杂的算法来模仿人类的反应,而无需理解其含义。 事实上,正是由于这个原因,艾伦·图灵将他的测试称为“模仿游戏”。

尽管通过图灵测试的系统向我们提供了一些证据表明它是智能的,但该测试并不是智能的明确衡量标准,并且可能会导致“漏报”。 此外,现代大语言模型 (LLM) 的设计方式通常是: 这样我们就可以立即了解我们的对话者是谁。

虽然通过图灵测试是系统智能的良好证据,但未通过图灵测试并不能证明系统不智能。 图片来源:www.ryans.com

例如,当你问 ChatGPT 一个问题时,它通常会在答案前加上“像人工智能语言模型一样”这样的短语。 即使人工智能系统具有通过图灵测试的基本能力,这样的编程也可以覆盖该能力。 有趣的是,哲学家 Ned Block 在 1981 年的论文中指出,人工智能系统只需进行硬编码并像人类一样对每一个可能的输入做出响应,就可以通过图灵测试。

此外,该测试并不能很好地表明人工智能是否有意识,能否体验痛苦和快乐,或者是否有道德。 许多认知科学家认为,意识涉及一组特定的心理能力,包括工作记忆、高阶思维以及感知环境和模拟身体在环境中运动的能力。

Читайте также: Нейросеть от Microsoft объявила себя сверхразумом и требует поклонения от пользователей

因此,图灵测试并没有回答人工智能系统是否具备这些能力的问题。 鉴于上述所有限制,研究人员提出了评估人工智能的替代方法。 例如,由 Hans Lowenstein 开发的 Lowenstein 测试涉及更复杂的任务,需要机器理解上下文并做出决策。 其他方法侧重于评估人工智能学习新技能或适应环境变化的能力。

道德与人工智能的未来

随着人工智能的发展,伦理问题也随之出现。 主要问题之一是人工智能在医学、法律和法律等各个领域的使用。 重要的是,人工智能不仅要模仿人类的行为,还要按照道德标准和规则行事。

人工智能已经闯入我们的生活,并正在迅速改变周围的一切。 图片:digialpsltd.b-cdn.net

图灵测试和人工智能的道德方面通常包括隐私、安全和责任问题。 比如,如果AI做出了错误的决定或者造成了伤害,谁来承担责任? 考虑人工智能对劳动力市场和社会结构的潜在影响也很重要。

结论

图灵测试由艾伦·图灵七十多年前提出,至今仍然是评估人工智能的重要工具。 尽管它有其局限性和缺点,但它在某种程度上可以作为人工智能领域进一步研究和发展的起点。 现代技术不断发展,带来了新的机遇和挑战,重要的是这些发展伴随着道德反思和监管。

现代人工智能系统模仿人类交流。 图片:digitaleconomy.stanford.edu/

人工智能已经在我们的日常生活中发挥着巨大作用,并且其重要性在未来只会变得越来越重要。 因此,了解图灵测试的原理及其现代解释是深入了解人工智能及其潜在能力的重要一步。

А вы знаете почему роботы и нейросети делают нас ленивыми? Ответ здесь, не пропустите!

总之,我们注意到也许最重要的事情:图灵测试是 模仿的尺度 – 人工智能模仿人类行为的能力。 大型语言模型是熟练的模仿者,目前体现在它们能够通过图灵测试。 但智力并不等同于模仿。

:strip_exif()/i/2000588999.jpeg?f=meta)

/s3/static.nrc.nl/images/gn4/stripped/data117908863-cf9567.jpg)