盖蒂图片社

在人工智能领域,所谓的“小语言模型”最近越来越受欢迎,因为它们可以在本地设备上运行,而不需要云中的数据中心级计算机。 周三,苹果 介绍 一组名为 OpenELM 的小型可用源 AI 语言模型,它们足够小,可以直接在智能手机上运行。 目前它们主要是概念验证研究模型,但它们可以构成苹果未来设备上人工智能产品的基础。

Apple 的新 AI 模型统称为 OpenELM,意为“开源高效语言模型”,目前可在 抱脸 在一个 Apple 示例代码许可证。 由于许可证中有一些限制,因此可能不适合 普遍接受的定义 “开源”,但 OpenELM 的源代码是可用的。

周二,我们介绍了 Microsoft 的 Phi-3 模型,该模型的目标是实现类似的目标:在可以本地运行的小型 AI 模型中实现有用的语言理解和处理性能水平。 Phi-3-mini 具有 38 亿个参数,但 Apple 的一些 OpenELM 模型要小得多,八个不同模型的参数范围从 2.7 亿到 30 亿不等。

相比之下,Meta 的 Llama 3 系列中迄今为止发布的最大模型包含 700 亿个参数(4000 亿个版本即将推出),而 OpenAI 的 GPT-3 从 2020 年开始包含 1750 亿个参数。 参数计数是人工智能模型能力和复杂性的粗略衡量标准,但最近的研究重点是使较小的人工智能语言模型与几年前较大的语言模型一样有能力。

八个 OpenELM 模型有两种类型:四种为“预训练”模型(基本上是模型的原始、下一个令牌版本),四种为指令调整模型(针对指令跟踪进行了微调,这对于开发 AI 助手和聊天机器人):

广告

OpenELM 具有 2048 个令牌的最大上下文窗口。 这些模型是在公开数据集上进行训练的 精致网络,一个版本 桩 删除重复项后,子集 睡衣红,以及一个子集 卓玛 v1.6,苹果称其数据总量约为 1.8 万亿个代币。 令牌是人工智能语言模型用于处理的数据的碎片表示。

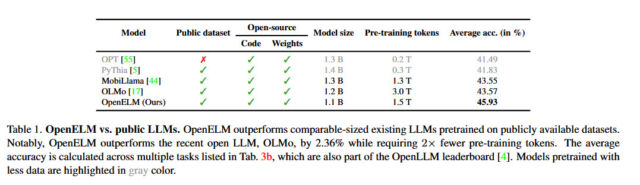

苹果表示,其 OpenELM 方法包括一种“逐层扩展策略”,据报道,该策略可以在每一层上更有效地分配参数,不仅节省计算资源,还可以提高模型的性能,同时使用更少的令牌进行训练。 根据苹果公司发布的 白皮书,该策略使 OpenELM 的准确率比 Allen AI 提高了 2.36% OLMo 1B (另一个小型语言模型),同时需要一半的预训练标记。

苹果

苹果还发布了代码 核心网,一个用于训练 OpenELM 的库,它还包括可重复的训练配方,允许复制权重(神经网络文件),这对于迄今为止的大型科技公司来说是不寻常的。 正如苹果公司在其 OpenELM 论文摘要中所说,透明度是该公司的一个关键目标:“大型语言模型的可重复性和透明度对于推进开放研究、确保结果的可信度以及对数据和模型偏差进行调查至关重要,因为以及潜在的风险。”

苹果表示,通过发布源代码、模型权重和培训材料,其目的是“增强和丰富开放研究社区的能力”。 然而,它也警告说,由于这些模型是在公开来源的数据集上进行训练的,“这些模型可能会根据用户提示产生不准确、有害、有偏见或令人反感的输出。”

虽然苹果尚未将这一波新的 AI 语言模型功能集成到其消费设备中,但据传即将推出的 iOS 18 更新(预计将于 6 月在 WWDC 上发布)将包含新的 AI 功能,这些功能利用设备上的处理来确保用户隐私——尽管该公司可能会聘请谷歌或 OpenAI 来处理更复杂的、设备外的人工智能处理,从而为 Siri 带来期待已久的提升。

1714080994

2024-04-25 20:55:43

#苹果发布八种针对设备上使用的小型人工智能语言模型