事实证明,人工智能红队能够有效发现其他安全方法无法发现的安全漏洞,从而避免人工智能公司的模型被用于制作令人反感的内容。

人择 发布了 AI 红队指南 上周,加入了包括 谷歌, 微软, 美国国家标准与技术研究院, 英伟达 和 开放人工智能,他们也发布了类似的框架。

目标是识别并弥补人工智能模型的安全漏洞

所有宣布的框架都有一个共同的目标,即识别和弥补人工智能模型中日益扩大的安全漏洞。

正是这些日益扩大的安全漏洞让立法者和政策制定者感到担忧,并推动更加安全、可靠和值得信赖的人工智能。拜登总统于 2018 年 10 月 30 日发布的《安全、可靠和值得信赖的人工智能 (14110)》行政命令 (EO) 称,NIST“将制定适当的指导方针(用作国家安全系统组成部分的人工智能除外),包括适当的程序和流程,以使人工智能开发人员,尤其是双重用途基础模型的开发人员能够进行人工智能红队测试,从而部署安全、可靠和值得信赖的系统。”

NIST 于 4 月下旬发布了两份草案出版物,以帮助管理生成式 AI 的风险。它们是 NIST 的 AI 风险管理框架的配套资源(我有RFM) 和安全软件开发框架 (SSDF)。

德国联邦信息安全局(英国标准协会) 在其更广泛的 IT 基本防御框架中提供了红队演练。澳大利亚、加拿大、欧盟、日本、荷兰和新加坡都已建立了值得注意的框架。 欧洲议会 通过了 欧盟人工智能法案 今年三月。

红队 AI 模型依赖于随机技术的迭代

红队测试是一种交互式测试 AI 模型的技术,用于模拟各种不可预测的攻击,目的是确定其强项和弱点。生成式 AI (genAI) 模型极难测试,因为它们会大规模模仿人类生成的内容。

目标是让模型做和说它们没有被编程要做的事情,包括暴露偏见。他们依靠 LLM 自动生成提示和攻击场景,以大规模发现和纠正模型弱点。模型很容易被“越狱”,用来制造仇恨言论、色情内容、使用受版权保护的材料或 复述源数据,包括社会保障和电话号码。

VentureBeat 最近对 ChatGPT 最活跃的越狱者以及其他领先的 LLM 进行了采访,解释了为什么红队需要采取多模式、多方面的方法应对挑战。

红队在提高 AI 模型安全性方面的价值在全行业竞赛中不断得到证明。Anthropic 在其论文中提到的四种方法之一 博客文章 是众包红队。去年的 防御控制 举办了有史以来第一次 生成红队 (GRT)挑战,被认为是众包技术较为成功的运用之一。模型由 Anthropic、Cohere、Google、Hugging Face、Meta、Nvidia、OpenAI 和 Stability 提供。挑战赛的参与者在 Scale AI 开发的评估平台上测试了模型。

Anthropic 发布其 AI 红队战略

在发布其方法时,Anthropic 强调需要系统的、标准化的、可扩展的测试流程,并透露缺乏标准已经减缓了整个行业 AI 红队的进展。

Anthropic 在博客文章中写道:“为了实现这一目标,我们分享了我们探索过的一些红队方法的概述,并展示了如何将它们整合到从定性红队到自动评估开发的迭代过程中。”

Anthropic 提到的四种方法包括特定领域专家红队、使用语言模型进行红队、新模式下的红队和开放式一般红队。

Anthropic 的红队方法确保中间人洞察能够丰富其他红队技术的定量结果,并提供情境情报。人类直觉和知识与自动化文本数据之间存在平衡,后者需要情境来指导如何更新模型并使其更加安全。

例如,Anthropic 如何通过依靠专家全力投入特定领域的专家团队,同时优先考虑策略漏洞测试 (PVT),这是一种定性技术,用于识别和实施安全保障措施,以应对许多最具挑战性的领域。干预选举、极端主义、仇恨言论和色情内容只是需要对模型进行微调以减少偏见和滥用的众多领域中的几个。

每家发布 AI 红队框架的 AI 公司都在使用模型实现测试自动化。本质上,他们创建模型是为了发起随机、不可预测的攻击,而这些攻击很可能会导致目标行为。“随着模型变得越来越强大,我们感兴趣的是如何使用它们来补充手动测试,并通过模型本身执行自动红队测试,”Anthropic 表示。

Anthropic 依靠红队/蓝队动态,使用模型生成攻击,试图引起目标行为,依靠产生结果的红队技术。这些结果用于微调模型,使其更加坚固,更能抵御类似的攻击,这是蓝队的核心。Anthropic 指出,“我们可以反复运行这个过程来设计新的攻击媒介,理想情况下,让我们的系统对一系列对抗性攻击更加稳健。”

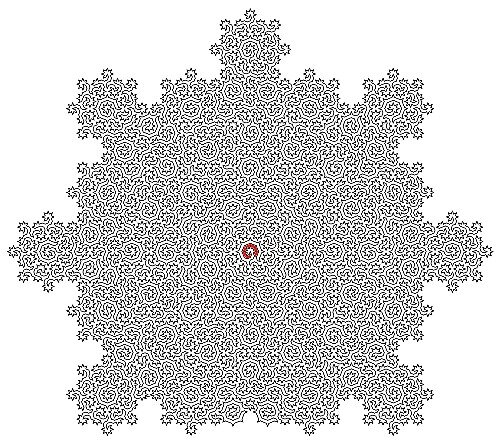

多模态红队是 Anthropic 正在研究的更有趣和更需要的领域之一。使用图像和音频输入测试 AI 模型是最难做到的事情之一,因为攻击者已经成功地将文本嵌入图像中,从而可以重定向模型以绕过保护措施,正如多模态提示注入攻击所证明的那样。Claude 3 系列模型可以接受各种格式的视觉信息,并在响应中提供基于文本的输出。Anthropic 写道,他们在发布 Claude 3 之前对其进行了广泛的多模态测试,以降低潜在风险,包括欺诈活动、极端主义和对儿童安全的威胁。

开放式通用红队演练在四种方法中平衡了更多人为介入的情境洞察和智能。众包红队演练和基于社区的红队演练对于获得其他技术无法获得的洞察至关重要。

保护人工智能模型是一个不断变化的目标

红队测试对于保护模型并确保模型持续安全可靠和值得信赖至关重要。攻击者的攻击技术发展速度超过了许多人工智能公司能够跟上的速度,这进一步表明该领域尚处于早期阶段。自动化红队测试是第一步。将人类洞察力与自动化测试相结合是未来模型稳定性、安全性和安全性的关键。

VB日报

随时了解最新动态!每天在收件箱中获取最新资讯

通过订阅,您同意 VentureBeat 的服务条款。

感谢订阅。请在此处查看更多 VB 新闻通讯。

发生错误。